Las autoridades del distrito Ambala de Haryana, a unos 215 kilómetros de la capital de la India, Nueva Delhi, anunciaron a finales de febrero el inicio de procedimientos para revocar los pasaportes y visas de personas etiquetadas como “alborotadores” que habían participado rompiendo barricadas o creando perturbaciones en la frontera de Punjab en medio de la reciente protesta de los agricultores.

Confirmaron que los perpetradores fueron identificados mediante tecnología de reconocimiento facial, un software monitoreado mediante el uso de cámaras CCTV y drones.

Esta no era la primera vez que se utilizaba tecnología de vídeo para identificar a personas que participaban en protestas contra el actual gobierno indio, encabezado por el nacionalista hindú Narendra Modi.

De hecho, en 2020 se observó un patrón similar en los enfrentamientos que estallaron en Nueva Delhi, donde las autoridades dijeron que habían utilizado tecnología de reconocimiento facial para identificar y detener a numerosas personas.

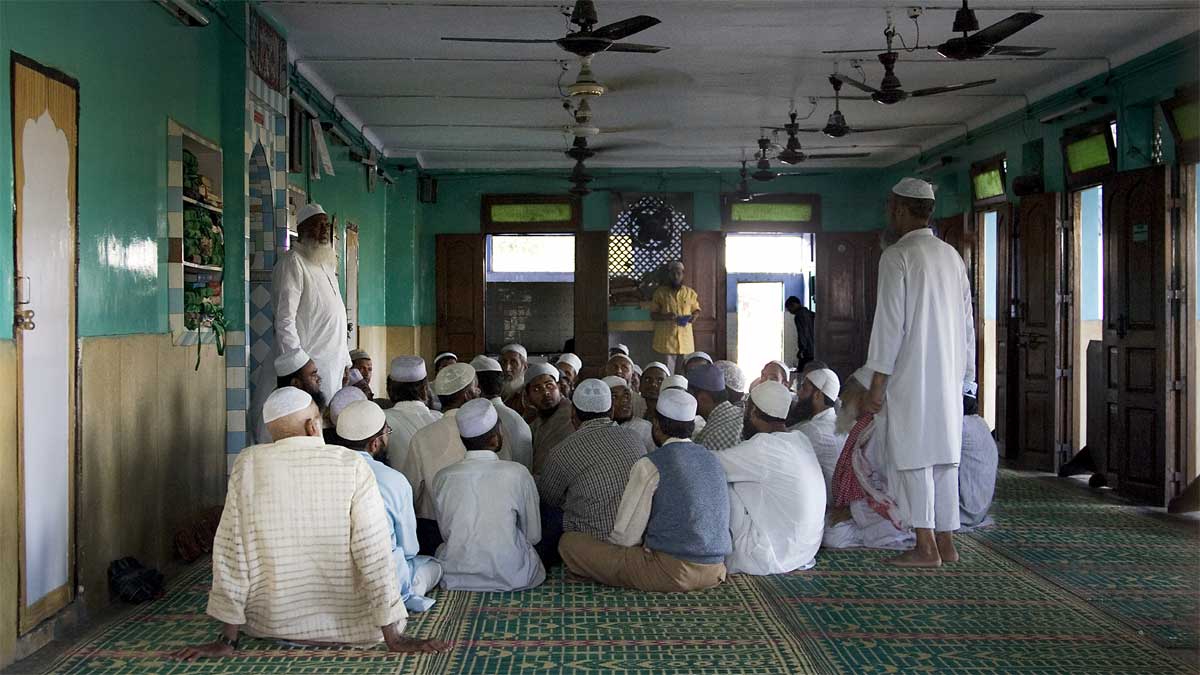

La mayoría de los acusados eran musulmanes, lo que provocó críticas de organizaciones de derechos humanos y expertos en tecnologías de la información con respecto a la utilización de la inteligencia artificial (IA) por parte de la India para centrarse en comunidades empobrecidas, minoritarias y marginadas en Delhi y otras partes del país.

Según un informe publicado por el Centro Vidhi de Política Legal, un grupo de expertos que trabaja para crear mejores leyes en la India, FRT se define como una tecnología que utiliza el aprendizaje automático u otras técnicas para identificar rostros.

Estas técnicas suelen requerir grandes cantidades de imágenes de rostros compiladas en lo que se llama una base de datos de entrenamiento.

El software utiliza esta base de datos de entrenamiento para «aprender» cómo hacer coincidir o identificar caras.

Si bien la definición puede parecer sencilla, los expertos en tecnología dijeron que hay poco debate sobre sus implicaciones éticas y quién utiliza este software.

Shivangi Narayan, miembro de la Red de Investigación de Gobernanza Algorítmica, dijo a Religion Unplugged que cuando damos tecnologías respaldadas por IA al personal policial, se vuelve imperativo ver a quién han estado apuntando «tradicionalmente».

«No es como las elites a las que la policía detiene», dijo. «Son las personas marginadas que ya están en las calles, haciendo su trabajo, las que son acosadas y atrapadas».

Añadió que el problema no está en el uso de cámaras para reforzar el trabajo policial, sino que los prejuicios que ya tienen las fuerzas del orden en la India se han vuelto muy evidentes. El uso de esta tecnología, añadió Narayan, sólo aumentará esos prejuicios y reprimirá a las minorías.

Problema con lecturas inexactas

El problema con FRT y el uso de otras tecnologías respaldadas por IA, como el sistema de red de seguimiento de delitos y delitos, se ve exacerbado aún más por las imprecisiones en sus resultados.

Tras una solicitud presentada por la Internet Freedom Foundation, la policía de Delhi afirmó que al utilizar FRT, trata todos los resultados por encima del 80 por ciento de similitud como positivos.

El informe también dice que el 80 por ciento de precisión depende de las condiciones de luz, la distancia y los ángulos faciales. Sin embargo, no estaba claro por qué se había elegido este punto de referencia para diferenciar entre resultados positivos y falsos.

En marzo de 2020, en una declaración del Ministro del Interior de la Unión, Amit Shah, se destacó que “más de 1.900 personas han sido identificadas a través del FRT por incitar a la violencia en la capital nacional durante los disturbios de Delhi”.

Disha Verma, asesora política asociada de IFF, dijo que una inexactitud del 20 por ciento, en términos de identificación de delincuentes, es una gran preocupación y que la policía de Delhi debería preocuparse por sus resultados.

«Una inexactitud del 20 por ciento significa que de cada 10 personas que la policía arresta a través del FRT, dos personas inocentes mal identificadas están siendo implicadas y presumidas culpables», dijo Verma.

“Incluso si se ignoran las violaciones de derechos aquí, esto tampoco es fructífero para las autoridades, ya que el Estado puede terminar gastando su tiempo, capacidad y recursos investigando a personas que no han cometido ningún delito simplemente debido a una tecnología defectuosa”.

Añadió que la ausencia de una ley sobre el FRT lo hace más peligroso. «No existe ninguna norma, política, directriz, procedimiento operativo estándar ni ley sobre el uso de FRT en la India», dijo Verma.

Violación de los derechos humanos en la India

Yash Giri, un abogado penalista, dijo que si bien el FRT ha generado debates nacionales e internacionales sobre sus posibles beneficios, también plantea riesgos para derechos humanos básicos y fundamentales como la privacidad, la igualdad, la libertad de expresión y la libertad de movimiento.

“India carece de una legislación sobre IA, pero sí posee una directiva del grupo de expertos gubernamental NITI Aayog, que enfatiza que los sistemas de IA deben abstenerse de discriminar por factores como religión, raza, casta, sexo, ascendencia, lugar de nacimiento o residencia», dijo. “Además, se insiste en realizar auditorías para garantizar su imparcialidad y ausencia de sesgos”, agregó.

Al comentar sobre el uso de tecnologías de inteligencia artificial en la vigilancia gubernamental, Verma destacó que es necesario que haya más transparencia por parte del gobierno de la India.

“Si bien los gobiernos sindicales y estatales parecen estar utilizando la IA como aceite de serpiente o como truco de marketing, o para emerger como líder global en el despliegue de la IA en algún momento, es necesario que se conozcan los detalles de cualquier sistema de IA en el que dependan para su gobernanza o vigilancia. hecho público”, dijo.

«Los gobiernos deben ser transparentes sobre la tecnología exacta que están utilizando y cómo toman decisiones, cuáles son las tasas de inexactitud y los riesgos de privacidad, y debe haber consultas adecuadas entre múltiples partes interesadas antes de lanzarse a integrar la IA en el sistema policial».

Rishabh Jain

Periodista independiente que vive en Delhi.

Fuente: Religion Unplugged.

Si te gustó o sirvió algo que publiqué, te ofrezco dos alternativas para agradecer y permitir la continuidad de mi trabajo en Bahía César, haciendo clic sobre ellas:

Introduce tu correo electrónico para suscribirte a Bahía César y recibir avisos de nuevas notas.