Aunque se trate de obras de ciencia ficción, novelas y adaptaciones cinematográficas como 2001: A Space Odyssey, de Stanley Kubrick, películas como Ex Machina, de Alex Garland, A.I. Artificial Intelligence, de Steven Spielberg, o clásicos de la literatura como los relatos recopilados en I, robot, de Isaac Asimov, han explorado las posibles relaciones entre los robots, la inteligencia artificial (IA) y las emociones.

«Aunque lo que vemos en esas obras aún queda lejos de la tecnología actual, las preguntas que abren son cada vez más relevantes para entender los efectos que la integración entre la IA y las emociones pueden llegar a tener en un futuro próximo de los avances tecnológicos», indicó Joan Casas-Roma, investigador postdoctoral del grupo SmartLearn de la Universitat Oberta de Catalunya (UOC) y doctor en sociedad de la información y el conocimiento por la UOC.

¿Dónde acaba lo humano y empieza lo artificial? ¿Cómo podría afectar en nuestras relaciones sociales la convivencia con robots capaces de entender y mostrar emociones?

Emociones percibidas: ¿realidad, o simulación?

Sin embargo, hay una pregunta fundamental y recurrente que ronda a menudo en la ciencia ficción y en las conversaciones alrededor del futuro de la tecnología: ¿podrá la IA llegar a tener emociones algún día?

«Es importante partir de una diferencia importante: una cosa es sentir emociones, y otra muy distinta es simular, o fingir emociones», indicó Casas-Roma. Esta distinción es clave porque, aunque en ambos casos podemos percibir, desde fuera, que hay una emoción presente, sabemos que la emoción no es genuina en los dos casos.

Por ejemplo, una actriz puede aparentar que está enojada con nosotros, pero sabemos que en realidad solo está simulando, o fingiendo sentir esa emoción, pero que no está realmente enojada.

Aunque la apariencia exterior de un amigo que se enojó con nosotros y una actriz que actúe como si estuviera enfadada será muy parecida, sabemos que la experiencia subjetiva que ambas personas tendrán de esa emoción es muy distinta.

Surge entonces la pregunta: ¿dónde está el límite de nuestra capacidad para distinguir, claramente, si un agente externo realmente siente una experiencia, o si solo actúa “como si” lo hiciera?

¿Por qué a menudo, los seres humanos somos capaces de proyectar y casi sentir nosotros mismos las sensaciones, experiencias y emociones que vemos en otros?

¿Cómo funciona ese mecanismo? ¿Lo hacemos por defecto con otras personas, con animales, o a veces incluso con objetos?

Proyectando y simulando otras mentes: la empatía con robots

En forma independiente de si un agente externo puede llegar a sentir emociones genuinas, una cosa es innegable: los seres humanos tendemos a atribuir estados mentales: emociones, intenciones, creencias, etcétera, a prácticamente todo lo que nos rodea.

Dentro de las ciencias cognitivas, el campo de la teoría de la mente investiga la forma en que los seres humanos atribuimos una “mente” a otros seres. También sucede lo propio con la forma en que usamos esas atribuciones para entender, explicar y predecir sus acciones y comportamientos.

«Uno de los posibles enfoques usado para explicar cómo funciona este mecanismo se llama teoría de la simulación y parte de la base que, para entender una mente externa a la nuestra, creamos una simulación de lo que creemos que está pasando por esa mente con tal de imaginar su punto de vista, entender las emociones que puede estar sintiendo, e incluso intentar predecir cómo actuará en función de sus deseos y objetivos. De esta capacidad de “imaginar” lo que debe estar pasando dentro de una mente diferente a la nuestra nacería, precisamente, la empatía: de la capacidad entender, simular y “sentir” lo que otra persona está experimentando o, dicho de otro modo, la capacidad de ponernos en sus zapatos», añadió el experto de la UOC.

Para el especialista, esa capacidad que tenemos para empatizar con otros seres, que se suele desarrollar típicamente entre los dos y los cuatro años como consecuencia de entender que existen “mentes diferentes” a la propia mente, es clave para la forma en que nos relacionamos socialmente con otros seres humanos y con el mundo que nos rodea; eso hace que, cuando no se desarrolla de forma correcta, pueda conllevar diversos problemas de relación con los demás.

Sin embargo, la empatía no es un vínculo que solo se pueda establecer entre mentes que reconocemos como ‘humanas’. “Más allá de la empatía que normalmente desarrollamos con respecto a animales no humanos, los seres humanos tendemos a atribuir una mente a prácticamente todo lo que nos rodea, cosa que nos lleva a menudo a hablar, aunque sea de forma metafórica, en términos de intenciones, deseos y emociones de elementos que, en realidad, no los tienen», explicó el investigador.

Ese proceso de atribución de una mente análoga a la nuestra a casi todo es conocido como antropomorfización. Se trata de un recurso que se usa y se explota extensamente en el ámbito de la ficción.

Esta tendencia de los seres humanos para atribuir una mente a agentes exteriores y empatizar con nuestro entorno, tiene su aplicación evidente en el campo de la IA.

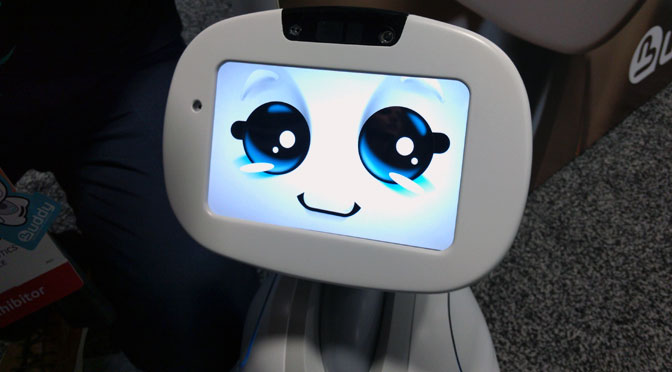

Desde la “humanización” de la voz de ciertos asistentes artificiales, como Siri en el caso de Apple, Alexa en el caso de Amazon, etcétera, la antropomorfización del aspecto de asistentes en ciertos programas como el clip asistente del Microsoft Word y sus sugerentes e incómodos juegos de cejas, la atribución de nombres y caras de perfil a algunos asistentes conversacionales (o chatbots), o la antropomorfización casi completa de robots de última generación, «todas esas técnicas hacen que sea más fácil crear relaciones empáticas con esas IA, así como atribuirles una mente y estados emocionales», añadió el investigador.

Robots, emociones y relaciones sociales: oportunidades y riesgos para el futuro

El contenido emocional de las interacciones es una parte central de la comunicación entre seres humanos. A través de este contenido entendemos a menudo mensajes que pueden no aparecer de forma explícita en lo que se dice, pero si en la forma en como se dice.

Eso puede ser útil en especial en casos, por ejemplo, como el de los robots diseñados para el cuidado médico. En estos casos, los robots no solo tienen que desempeñar un papel puramente funcional, sino que, al relacionarse con pacientes humanos que pueden estar en momentos de vulnerabilidad, o en situaciones emocionales complicadas, poder “leer” y responder apropiadamente a las emociones del paciente humano puede hacer que la interacción sea mucho más reconfortante para éste.

Según el experto de la UOC, «esto no significa, por supuesto, que el paciente deba creer, como requisito para que la interacción sea más agradable, que el robot realmente siente esas emociones, pero al ver que esa interacción tiene en cuenta su estado de ánimo podría ayudar al paciente a sentir que el robot, en cierto modo, “entiende” lo que le pasa y le proporciona un mejor acompañamiento en esa situación de vulnerabilidad».

Sin embargo, estos avances también pueden tener un lado oscuro. Como ya sucedió en la historia de la tecnología, podrían usarse de formas menos deseables.

Al saber que los seres humanos tendemos a empatizar y a adaptar nuestras interacciones con agentes en los que proyectamos una mente, el hecho de leer y simular emociones podría utilizarse para manipular, de forma sutil y casi inconsciente, nuestras propias decisiones con fines comerciales, políticos o ideológicos.

Otro riesgo que se esconde tras la capacidad de la IA para entender y reaccionar a las emociones es la posibilidad de que las relaciones sociales se “tecnifiquen”.

De la misma forma en que una IA capaz de percibir y reaccionar a estados emocionales está aprendiendo las “reglas” de las relaciones sociales, existe el riesgo de que nosotros mismos, ya sea cuando interaccionamos con una IA, o ya sea de forma creciente en las relaciones sociales con otras personas, empecemos a basar esa tipo de interacciones en las “reglas” que hay detrás, más que en nuestra propia intuición natural para hacerlo.

Si, a través de potenciar las relaciones emocionales con sistemas de IA basados en regla, nos estamos entrenando a nosotros mismos para entender las reglas detrás y aprender a “jugar al juego” de las interacciones sociales, ¿existe el riesgo de que nos estemos entrenando, en el fondo, para calcular, fingir y manipular el uso de las emociones para obtener la respuesta que queremos?

La creciente capacidad de los sistemas de IA para percibir y mostrar emociones abre las puertas a una nueva dimensión de las interacciones sociales entre los seres humanos y las máquinas.

Detrás de esa puerta hay grandes oportunidades para hacer de nuestra interacción con los sistemas de IA algo más natural, orgánico, gratificante y eficaz, pero también hay riesgos potenciales que apuntan tanto a un posible uso malintencionado de esas tecnologías, como a los posibles efectos que esta tecnificación de las interacciones sociales pueda tener sobre las relaciones entre los propios seres humanos.

«Como en la mayoría de los avances tecnológicos, es muy difícil prever en qué y hasta qué punto este avance afectará el futuro de nuestra forma de relacionarnos. Sin embargo, hay un punto importante para tener en cuenta que nos puede dar valiosas herramientas para entablar esa nueva etapa de las relaciones entre las personas y las máquinas desde una posición más informada y con más herramientas para sacar el máximo provecho de dichos avances, al mismo tiempo que nos protegemos de posibles efectos adversos. Se trata de recordar la diferencia que hay entre una emoción genuina y una emoción simulada, y tener presente cuál de las dos es la que puede mostrar un sistema de IA», concluyó el investigador de la UOC.